ChatGPT / OpenAI anbinden

GREYHOUND unterstützt die Einbindung von KI-unterstützter Antwortgenerierung auf Basis von OpenAI Sprachmodellen (optional). So lassen sich per KI vollautomatisch Textantworten auf Anfragen via Chat oder Mail generieren – in Sekundenschnelle und erstaunlich passend.

Addon “GREYHOUND Connect für OpenAI” buchen

Um ChatGPT in GREYHOUND nutzen zu können, ist im GREYHOUND Control Center (GCC) das Addon “GREYHOUND Connect für OpenAI” dem bestehenden Vertrag hinzu zu buchen:

- Nach dem Login oben im Menü zu Verträge > V-123456789-0 > Produkte bearbeiten navigieren.

- Hier das Addon “GREYHOUND Connect für OpenAI” anhaken und die Änderungen prüfen sowie übernehmen.

Hinweis für Eigenbetriebler

- Kunden im Eigenbetrieb müssen sicherstellen, dass Port 9443 in der Firewall wie hier beschrieben eingehend und ausgehend freigegeben ist.

- Kunden im Eigenbetrieb müssen die Verwendung des gebuchten Addons ggfs. zusätzlich im GREYHOUND Admin aktivieren. Außerdem können die Funktionen des neuen Addons u. U. erst nach einem Neustart des GREYHOUND Clients verfügbar sein.

OpenAI in GREYHOUND nutzen

Es gibt zwei Wege, um OpenAI in GREYHOUND zu nutzen:

- Nativ über die OpenAI API

- Als Azure OpenAI Service*

*ab GREYHOUND 5.5.247 build 3781

Im Folgenden sind beide Wege beschrieben.

OpenAI API

Um die OpenAI API anzubinden, ist zunächst auf dieser Seite ein neuer OpenAI-Account zu erstellen (falls nicht schon vorhanden): https://openai.com/api/

Achtung

Es braucht einen API-Account bei OpenAI – NICHT einen ChatGPT-Account. Zudem muss im API-Account unter “Payment methods” eine gültige Zahlungsmethode hinterlegt sein.

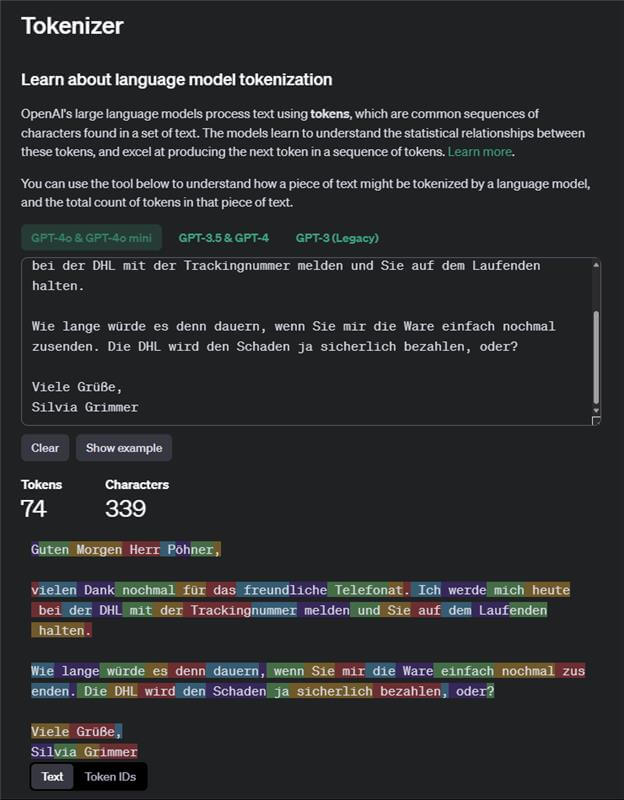

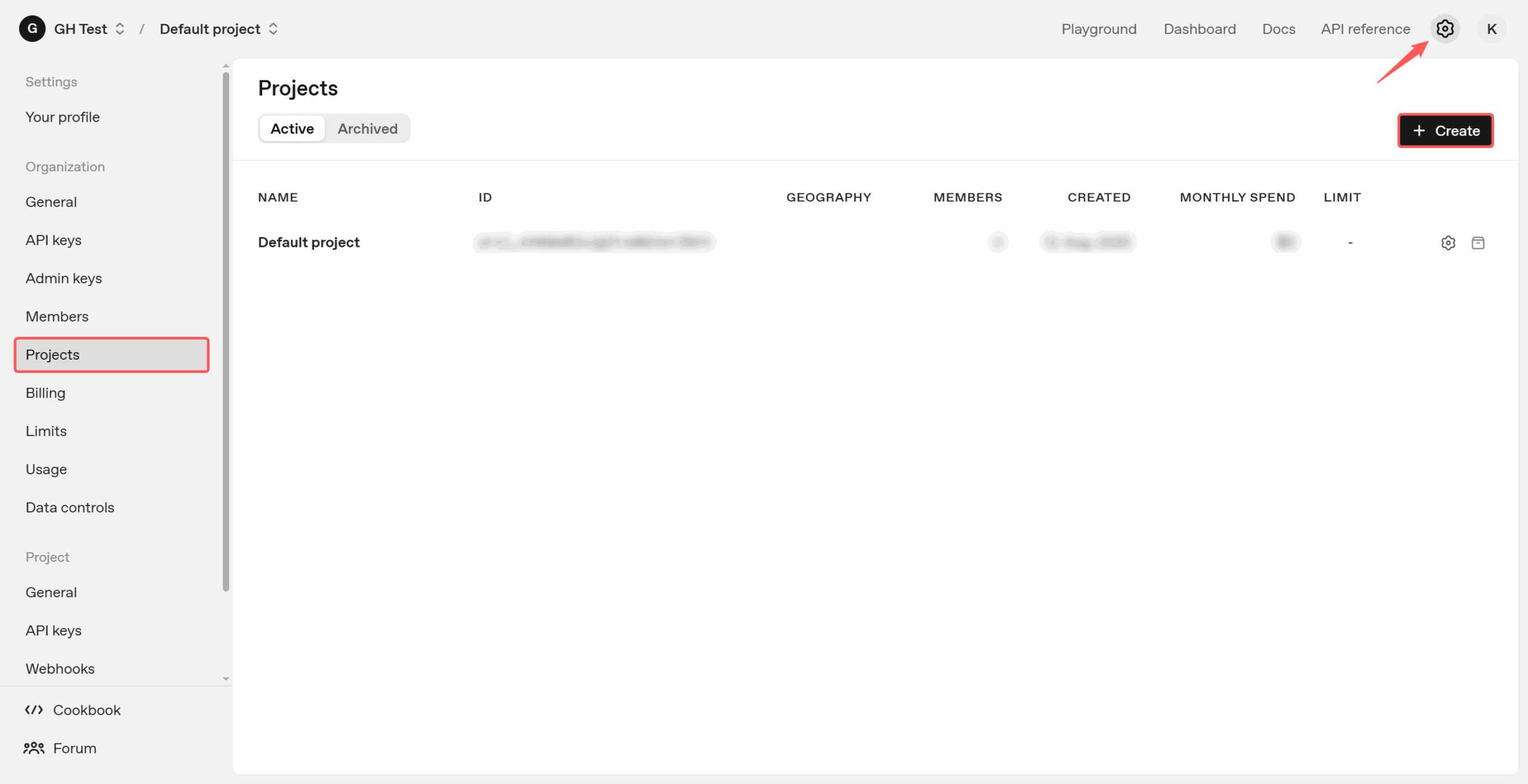

Wenn dies der erste Login in die OpenAI Platform sein sollte, muss zunächst eine Organisation angelegt werden. Danach können durch Klick auf das Zahnrad oben rechts die Einstellungen (Settings) aufgerufen werden. Hier ist im Menü links unter “Projects” ein neues Projekt anzulegen mit einem beliebigen Namen:

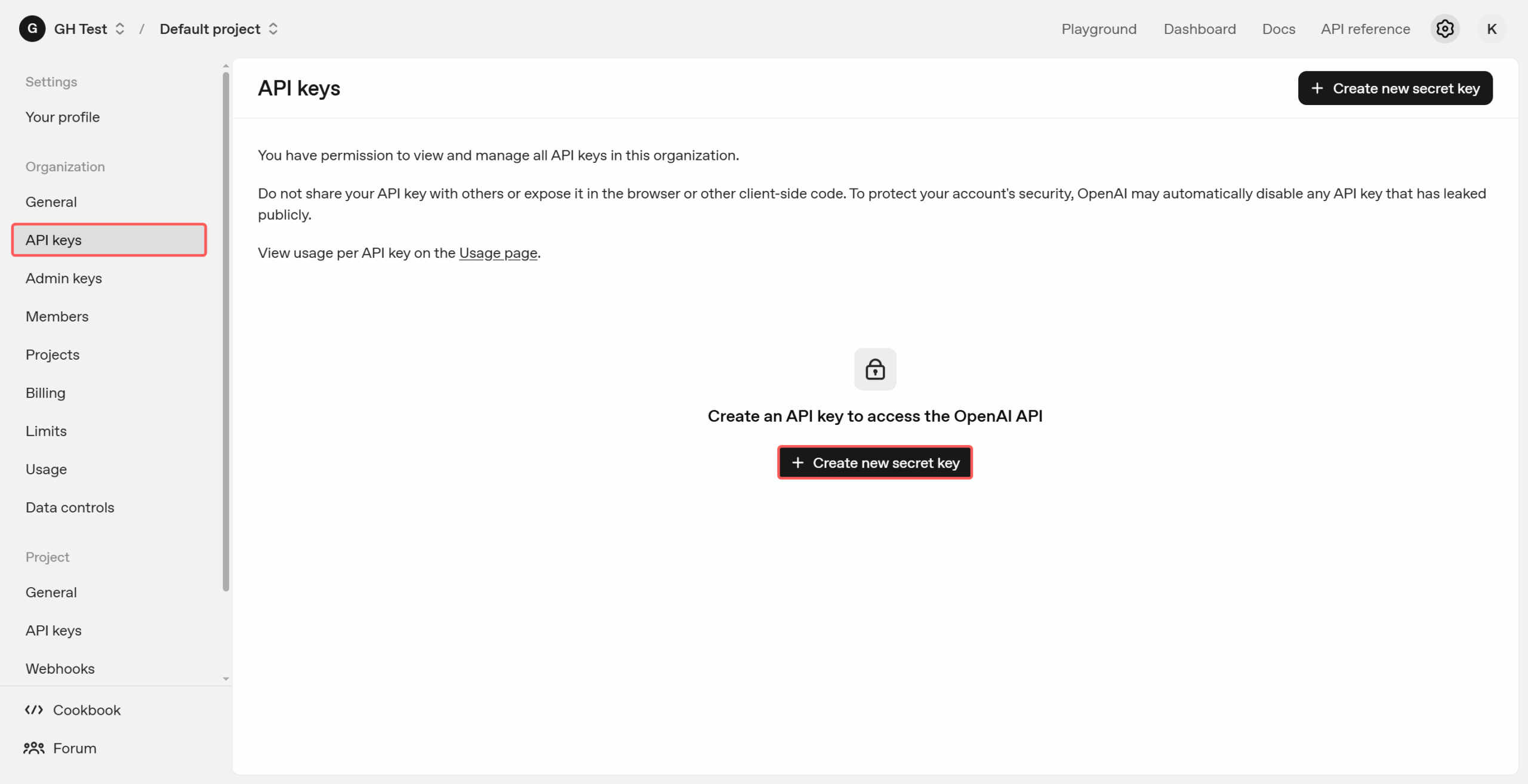

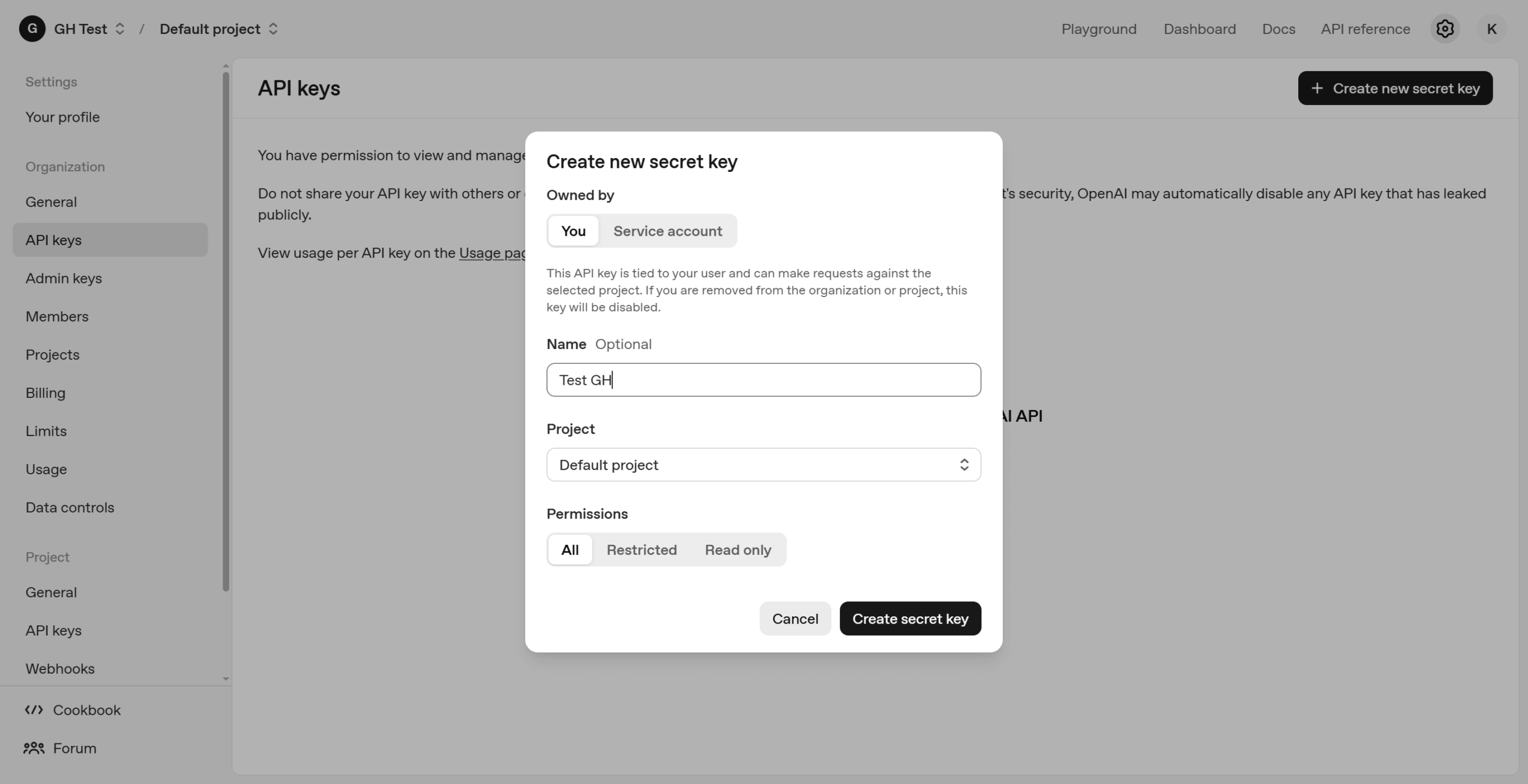

Anschließend kann im Menü links unter “API keys” durch Klick auf den Button „Create new secret key“ ein API-Schlüssel mit einem beliebigen Namen unter Zuordnung des zuvor angelegten Projekt mit “Permissions: All” erstellt werden, der nötig ist, um GREYHOUND und OpenAI zu verbinden.

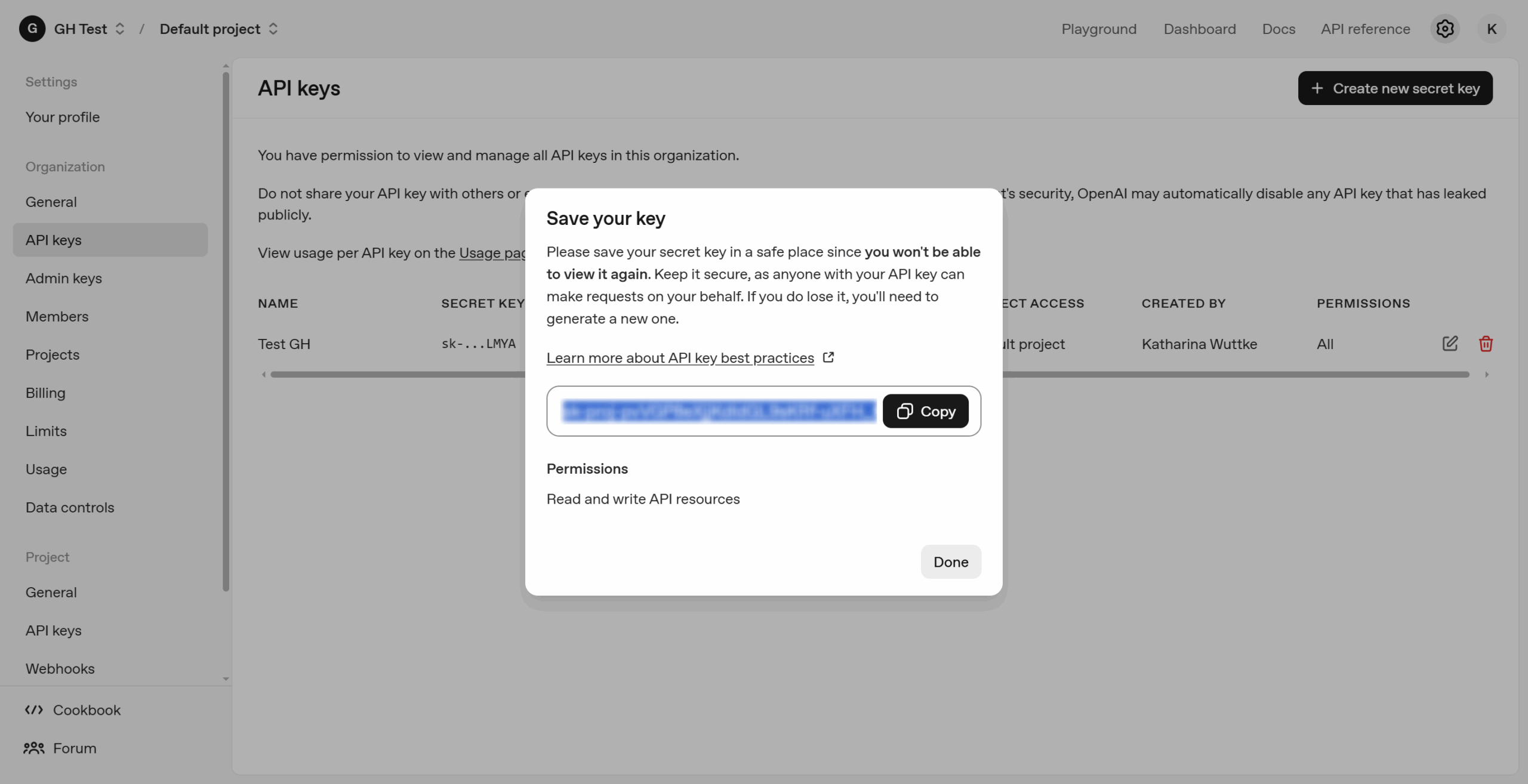

Dieser Schlüssel ist unbedingt sicher aufbewahren – man kann diesen später nicht mehr abrufen! Am besten behält man ihn griffbereit, denn der muss gleich in den GREYHOUND Servereinstellungen hinterlegt werden.

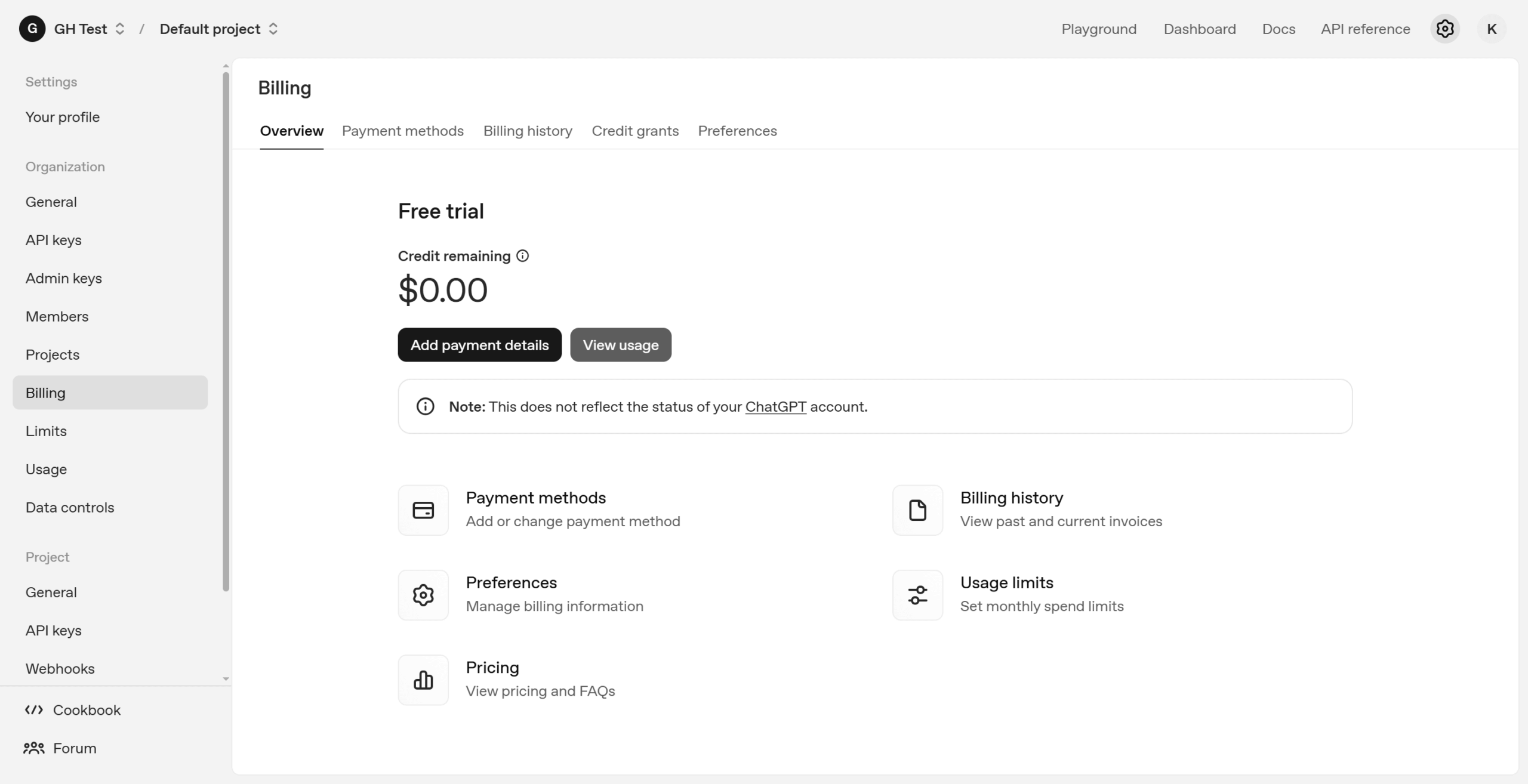

Weiter unten links im Menü gibt es den Punkt “Settings” und dort den Unterpunkt „Billing“. Hier muss noch eine “Payment method” hinterlegt werden – denn standardmäßig ist ein neu erstellter Zugang ein kostenloser Zugang. Um die API nutzen zu können, ist allerdings ein „Paid Plan“ nötig. Deshalb muss der Account nun einmal umgestellt werden in einen Bezahlaccount, d.h. unter „Payment methods“ muss eine Kreditkarte hinterlegt werden. Bei ChatGPT bzw. OpenAI zahlt man nach Verbrauch. Um keine unerwartet hohe Rechnung zu erhalten, ist es ratsam, sogenannte „Usage Limits“ zu definieren.

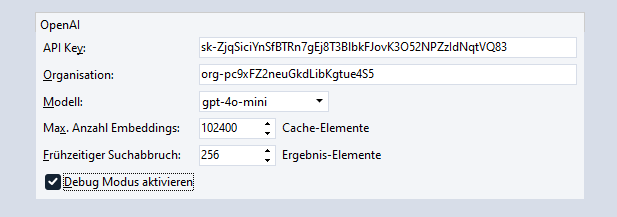

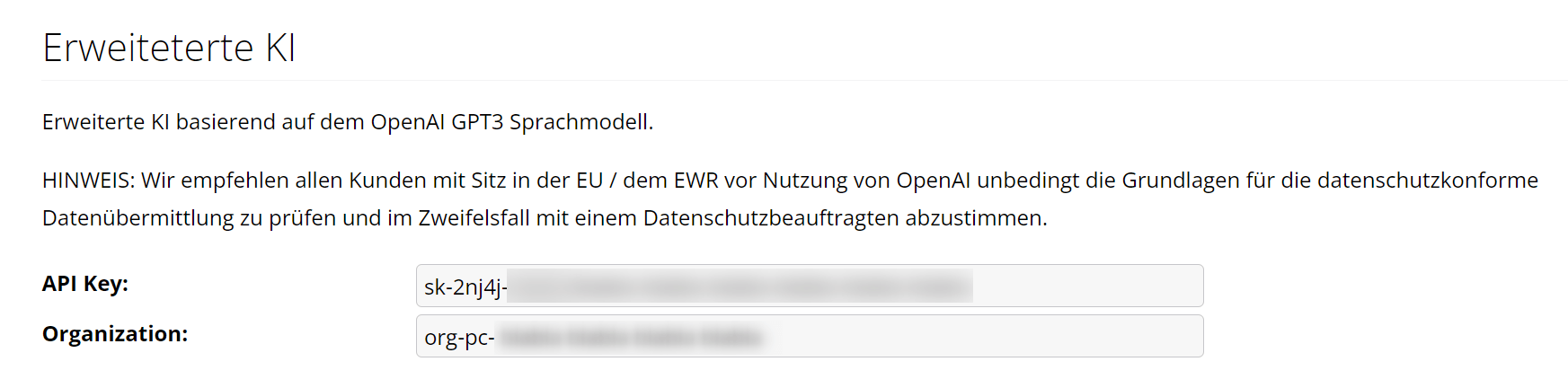

Anschließend können die API-Daten in GREYHOUND im Server wie folgt hinterlegt werden:

- Hosting-Kunden loggen sich bitte im GCC ein und navigieren sich dort oben im Menü zu Verträge > V-123456789-0 > Hosting-Paket. Auf dieser Seite auf den Button „Einstellungen“ klicken. Anschließend ganz unten scrollen, um auf den Button „Systemeinstellungen“ zu klicken. Auf der Seite, die sich dann öffnet, ganz nach unten bis zum Part „Erweiterte KI“ scrollen.

- Kunden im überwachten Eigenbetrieb loggen sich bitte im GCC ein und navigieren sich dort oben im Menü zu Verträge > V-123456789-0 > Eigene Server. Auf dieser Seite auf den grünen Namen des Servers klicken und anschließend auf den Button „Einstellungen“. Anschließend ganz unten scrollen, um auf den Button „Systemeinstellungen“ zu klicken. Auf der Seite, die sich dann öffnet, ganz nach unten bis zum Part „Erweiterte KI“ scrollen.

Um ChatGPT an GREYHOUND anzubinden, ist nun hier der individuelle API-Key sowie die „Organization“ aus OpenAI einzutragen:

Azure OpenAI Service

Um einen Azure OpenAI Service aufzusetzen, muss man folgende Schritte durchlaufen:

- Azure-Konto erstellen: Falls du noch kein Konto hast, erstelle eins auf Azure.com und logge dich ins Azure-Portal ein.

- Erstellen einer Azure OpenAI Ressource: Navigiere im Azure-Portal zur Suchleiste oben in der Mitte und suche nach “Azure OpenAI”. Wähle den Dienst “Azure OpenAI” aus und klicke auf “Create”. Wähle das entsprechende Abonnement und eine bestehende Ressourcengruppe (oder erstelle eine neue). Gib der Ressource einen Namen, wähle die gewünschte Region und bestätige die Preisstufe (abhängig von deinem Budget). Bitte beachte, dass je nach gewählter Region hinterher unterschiedliche Modelle zur Verfügung stehen – wählt man Deutschland, stehen nur wenige Modelle zur Auswahl; bei wählt man hingegen Westeuropa als Region, stehen deutlich mehr Modelle zur Auswahl. Die Auswahl der Region ist in Abstimmung mit einem Datenschutzbeauftragten zu treffen. Klicke, wenn alles fertig ist, auf “Weiter”.

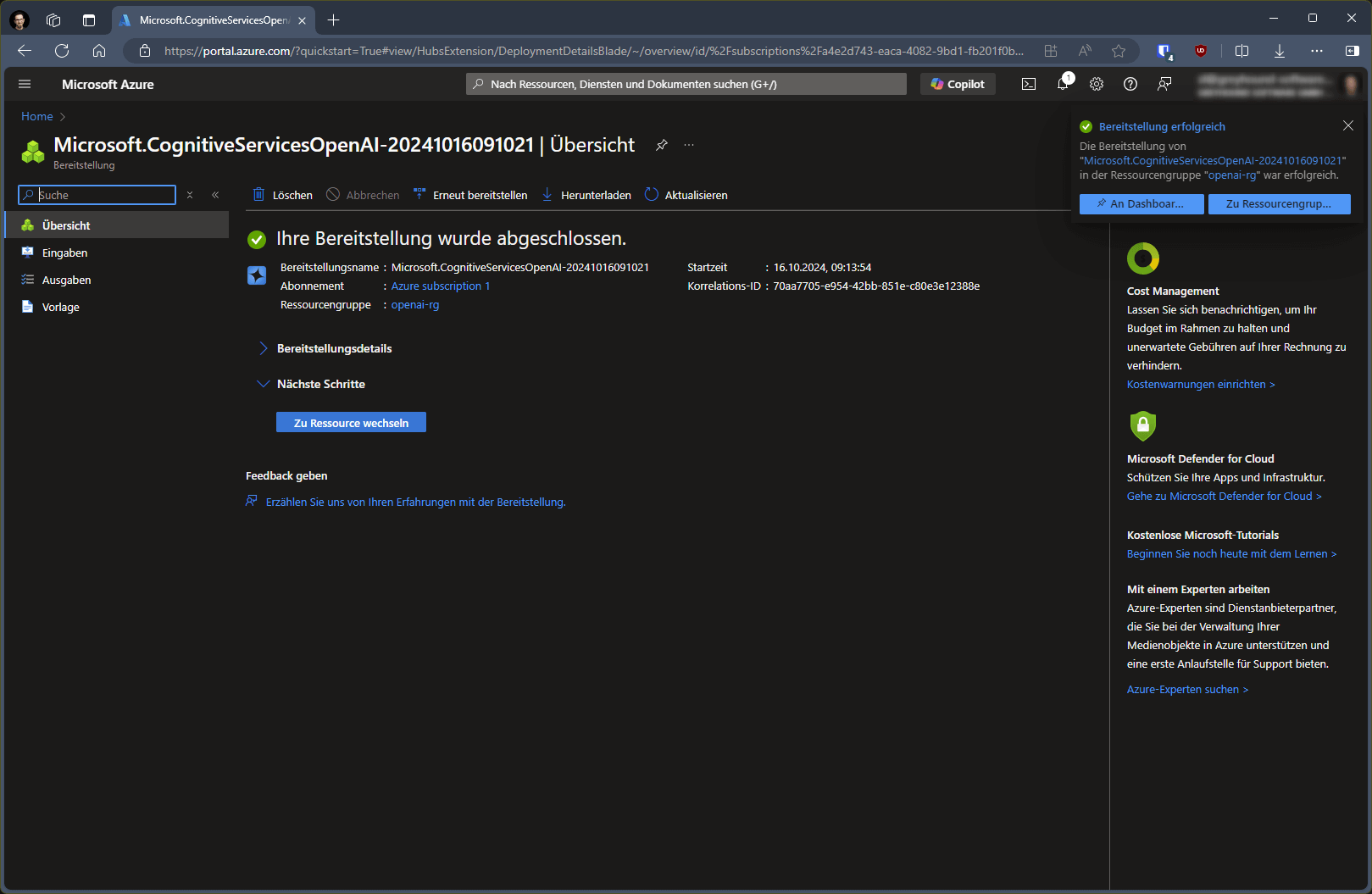

Sobald die Bereitstellung abgeschlossen ist, klicke auf den Button “Zu Ressource wechseln”:

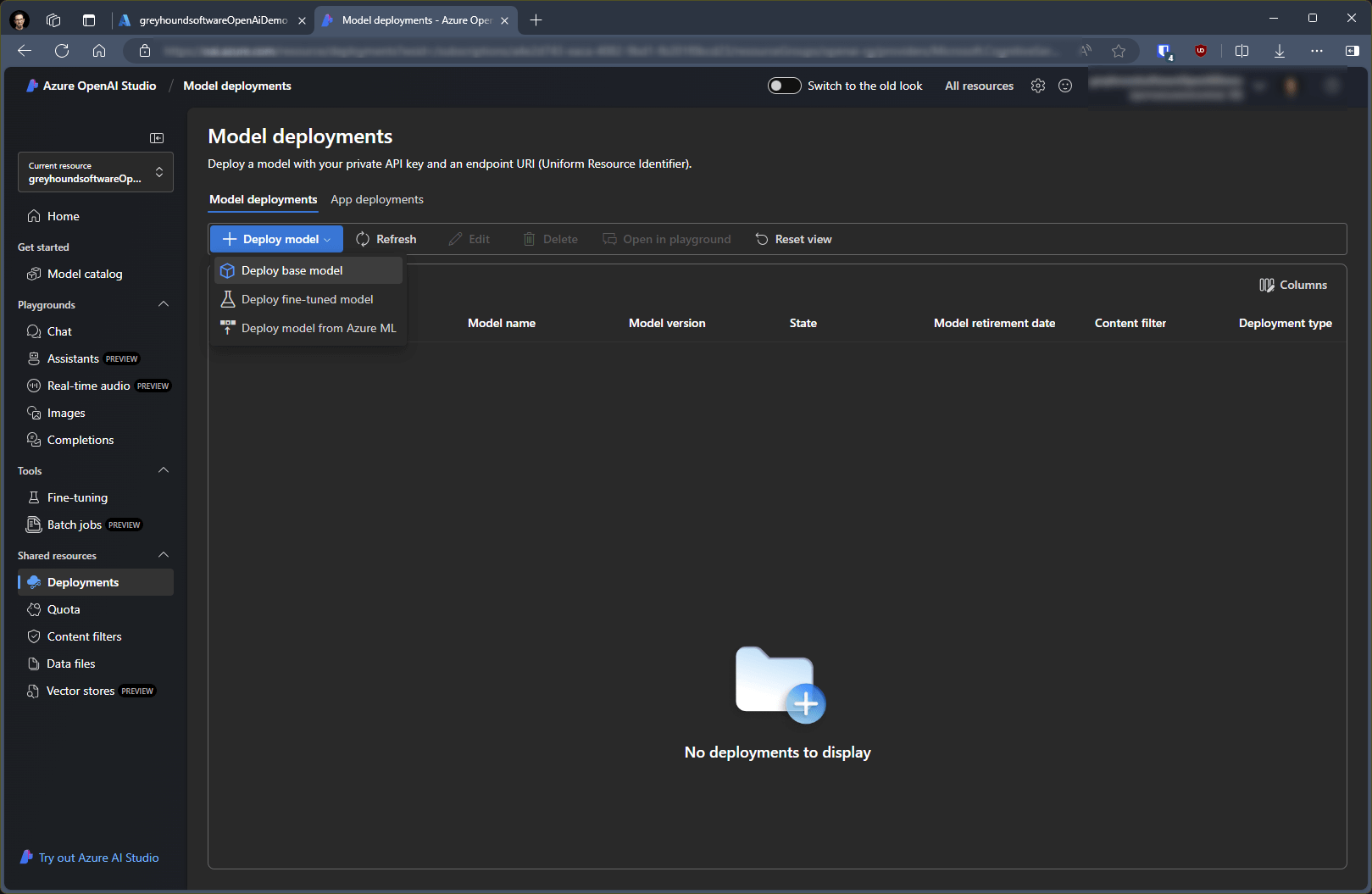

Nun lassen sich im Bereich “Model deployments” über einen Klick auf das Plus bei “Deploy model” und “Deploy base model” die nötigen OpenAI-Modelle auswählen, die man an GREYHOUND anbinden möchte:

Als Modelle stehen je nach gewählter Region unterschiedlich viele zur Auswahl. Mehr dazu hier. Was wir für GREYHOUND brauchen, sind zwei verschiedene Modell-Typen: Ein “Chat-Completion Model” für Sprachverständnis und -ausgabe jeglicher Art und ein “Embedding Model” für die Weitergabe von internen Bestandsdaten aus dem Unternehmen, z.B. aus gesendeten E-Mails, die als Grundlagenwissen verwendet werden sollen. Embeddings sind die nötige Grundlage für die Verwendung des KI-Antwortvorschlags in GREYHOUND.

Für jedes Modell bekommt man bei Nutzung von Azure Open AI jeweils einen eigene API URL, die im GREYHOUND Server angebunden wird.

Unsere Empfehlung zum aktuellen Zeitpunkt ist gpt-4o für Chatbots, automatische Antworten, Themenerkennung & Dokumentenerkennung oder das etwas günstigere gpt-4o-mini für die gleichen Zwecke. Im Bereich Embedding ist unsere Empfehlung zum aktuellen Zeitpunkt text-embedding-3-small oder text-embedding-ada-002.

Hinweis: Ändert man das Embedding-Modell nachträglich, müssen in GREYHOUND alle Embedding neu erstellt werden. Das dauert etwas und kostet ein wenig.

- Sobald die gewünschten Modelle ausgewählt sind, ist im Bereich “Models” für jedes Modell der API-Schlüssel über den Abschnitt “Keys and Endpoints” aufzurufen – dieser wird nun in GREYHOUND hinterlegt.

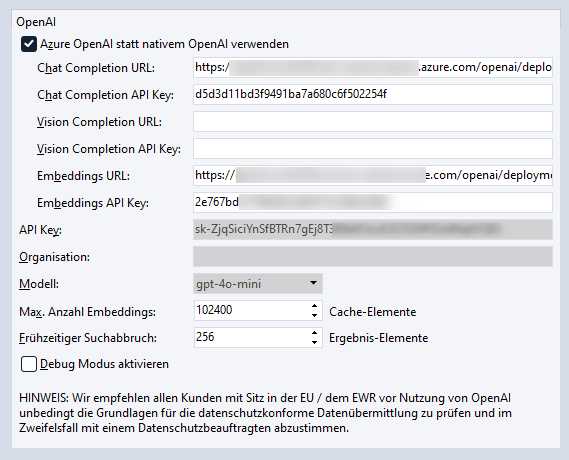

- Sobald der Azure OpenAI Service aufgesetzt ist, können die API-Daten in GREYHOUND im Server wie folgt hinterlegt werden:

- Hosting-Kunden loggen sich bitte im GCC ein und navigieren sich dort oben im Menü zu Verträge > V-123456789-0 > Hosting-Paket. Auf dieser Seite auf den Button „Einstellungen“ klicken. Anschließend ganz unten scrollen, um auf den Button „Systemeinstellungen“ zu klicken. Auf der Seite, die sich dann öffnet, ganz nach unten bis zum Part „OpenAI“ scrollen und den Haken setzen bei “Azure OpenAI statt nativem OpenAI verwenden“.

- Kunden im überwachten Eigenbetrieb loggen sich bitte im GCC ein und navigieren sich dort oben im Menü zu Verträge > V-123456789-0 > Eigene Server. Auf dieser Seite auf den grünen Namen des Servers klicken und anschließend auf den Button „Einstellungen“. Anschließend ganz unten scrollen, um auf den Button „Systemeinstellungen“ zu klicken. Auf der Seite, die sich dann öffnet, ganz nach unten bis zum Part „OpenAI“ scrollen und den Haken setzen bei “Azure OpenAI statt nativem OpenAI verwenden“.

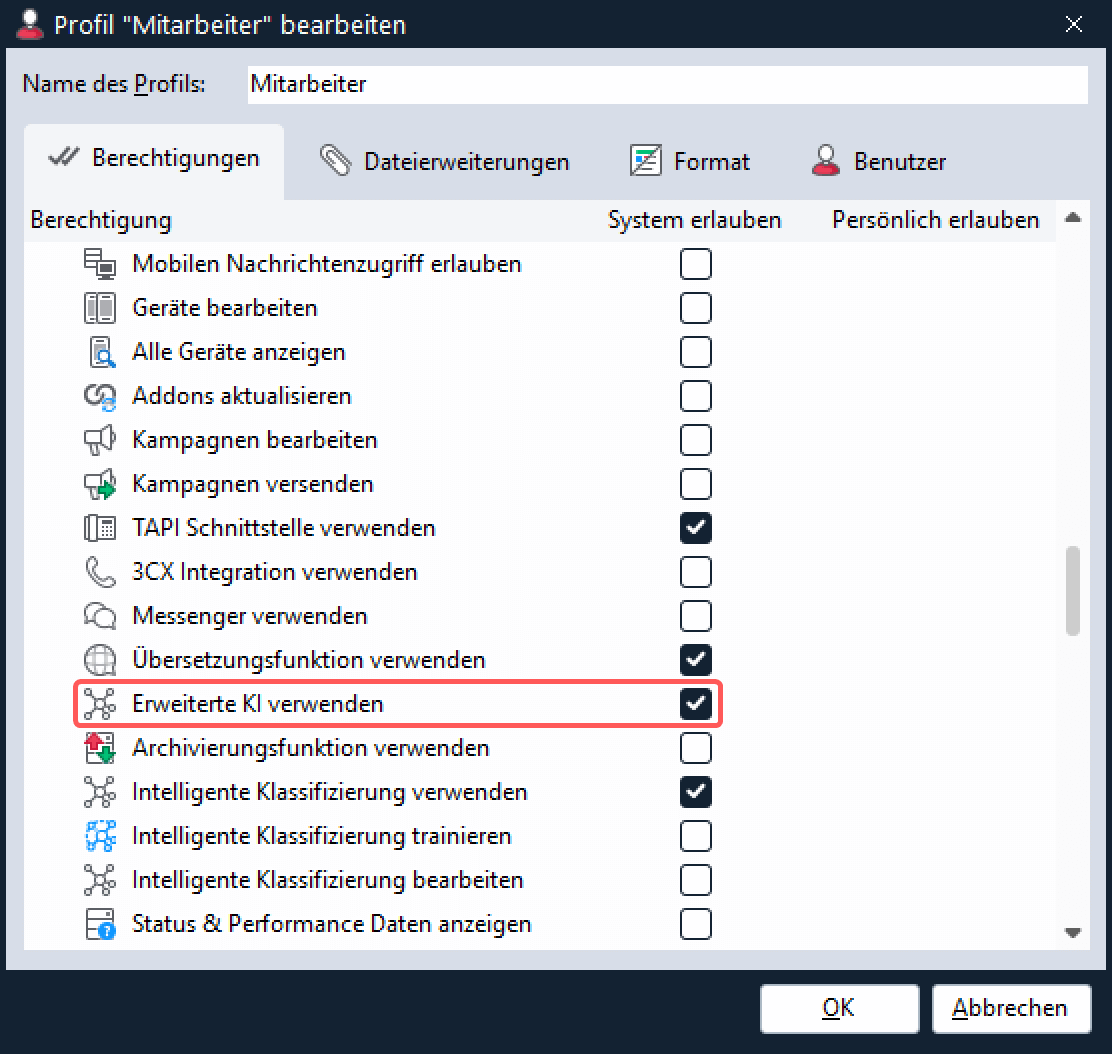

Die erforderlichen Rechte vergeben

Für alle Benutzer, die automatische Textvorschläge von der KI generieren können sollen, ist unter Einstellungen > Profile das Recht “Erweiterte KI verwenden” zu setzen:

Datenschutzhinweise

Wenn ein eigener OpenAI Account genutzt wird, ist datenschutztechnisch Vorsicht geboten.

- Wer OpenAI (ChatGPT) eigenständig an GREYHOUND anbinden will, der muss wissen: OpenAI selbst erfasst erstmal per se keine personenbezogenen Daten – es sei denn, der Nutzer gibt diese ausdrücklich freiwillig ein. Aber natürlich speichert OpenAI die Daten, die Anwender eingeben, um Antworten zu generieren. Das ist ja der Sinn dieser KI – sie sammelt und konsolidiert alle Daten, die sie kriegen kann, um daraus zu lernen. Alles, was über diesen Kanal rein- oder rausgeht, landet also auf US-Servern und wird in irgendeiner Form weiterverarbeitet. Die Übertragung vom GREYHOUND Server zum OpenAI-Server erfolgt dabei SSL-verschlüsselt. Personenbezogene oder andere vertrauliche Daten sollten dennoch keinesfalls in ChatGPT / OpenAI einfließen! Vor der Anbindung ist es zwingend nötig, sich mit der Privacy Policy von OpenAI vertraut zu machen und individuell abzuwägen, ob ein DSGVO-konformer Einsatz möglich ist und wenn ja, unter welchen Voraussetzungen. Als Stichworte seien hier zu nennen: Drittlandübermittlung; Informationspflichten; Auftragsverarbeitungsvertrag und Transfer-Impact-Assessment; Grundsatz der Datenrichtigkeit; Unterscheidung von Trainingsdaten & Betriebsdaten sowie Rechtsgrundlage für die Verarbeitung – natürlich können wir an dieser Stelle nicht rechtlich im Detail auf alle Punkte eingehen.

- Wer auf den Einsatz von OpenAI nicht verzichten will, aber die Nutzung DSGVO-konform(er) gestalten möchte, kann den „Azure OpenAI Service“ verwenden (in GREYHOUND möglich ab 5.5.247 build 3781). Azure OpenAI Service bietet eine Möglichkeit, die KI-Modelle von OpenAI zu nutzen, ohne, dass Daten an OpenAI/ChatGPT übermittelt werden – sie verbleiben in der dedizierten Azure-Umgebung des Kunden und verlassen diese nicht. Die übertragenen Daten sind dabei NICHT für andere Kunden verfügbar und auch NICHT für OpenAI selbst verfügbar. Die Daten werden auch NICHT zur Verbesserung von OpenAI-Modellen verwendet oder um Produkte oder Dienste von Microsoft oder Drittanbietern zu verbessern. Durch die von Microsoft gegebenen Garantien ist der Einsatz von OpenAI in der Azure-Umgebung wesentlich datenschutzkonformer möglich als wenn die Standalone-Services von OpenAI / ChatGPT genutzt wird. Aber auch Azure OpenAI sollte lediglich nach sorgfältiger Abwägung von Alternativen und in enger Abstimmung mit dem Datenschutzbeauftragten eingesetzt werden!

Hinweis: Wir können an dieser Stelle keine (datenschutz-)rechtliche Beratung für unsere Kunden leisten.

Tipp: Wer anstelle von OpenAI das AI Pack bestehend aus AI Agent + AI Human Assist nutzt, für den gilt: JTL tritt als Auftragsverarbeiter auf. Dieser Weg ist datenschutzkonform. Der Betrieb erfolgt auf den West-Europa Servern von Microsoft und garantiert DSGVO-Konformität. Mehr erfahren.